Examen de cambio de sentido: detrás del algoritmo que desencadenó el caos de las calificaciones de nivel A

'Semillas del desastre de la política' sembradas en una carta enviada por Gavin Williamson cuando se anunció el cierre en marzo

'Semillas del desastre de la política' sembradas en una carta enviada por Gavin Williamson cuando se anunció el cierre en marzo

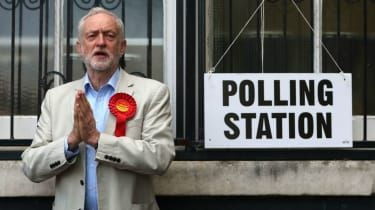

Chris J Ratcliffe / Getty Images

Cuando estalló la ira tras la publicación de las calificaciones A-level la semana pasada, el primer ministro Boris Johnson insistió en que los resultados eran sólidos, buenos y confiables para los empleadores.

Pero solo unos días después, tras la repentina retirada de Ofqual de los criterios para apelar las calificaciones, el gobierno se vio obligado a dar un vergonzoso cambio de sentido, y los resultados ahora se basarán en las predicciones de los profesores y no en los de un controvertido algoritmo.

El sistema automatizado se utilizó en un intento por evitar lo que el secretario de Educación, Gavin Williamson, describió como una inflación galopante en las calificaciones en medio del telón de fondo de la pandemia de coronavirus y los exámenes cancelados. Pero, ¿a quién se le ocurrió el algoritmo, que podría terminar costándole a Williamson su trabajo de gabinete?

Circunstancias sin precedentes

Las semillas del desastre de las políticas se sembraron el día en que entró en vigor el bloqueo, cuando Williamson advirtió en una carta a Ofqual que evitar la inflación de calificaciones era una prioridad. Los tiempos informes.

Ofqual debe garantizar, en la medida de lo posible, que se mantengan los estándares de calificación y que la distribución de calificaciones siga un perfil similar al de años anteriores, dijo Williamson al regulador de exámenes.

En otras palabras, dice el periódico, a pesar de que los alumnos no se presentaban a los exámenes, el gobierno quería tratar la promoción de 2020 como la de años anteriores. Los niveles A se trataron como el 'estándar de oro' del sistema educativo y no debían devaluarse.

Pero al encargar al regulador de exámenes que suscribiera una póliza de seguro en la forma de su algoritmo desafortunado, este deseo de limitar la inflación de calificaciones fue demasiado lejos, agrega el BBC .

¿Qué salió mal?

A petición del secretario de educación, los estadísticos del regulador se pusieron a trabajaridear un sistema de reparto de calificacioneseso no permitió que los resultados de los exámenes subieran con respecto a años anteriores, explica Jo-Anne Baird, profesora de evaluación educativa en la Universidad de Oxford y miembro del comité asesor de Ofqual.

El problema fue que en el caso de la clase Covid, la preocupación por mantener los estándares tuvo un precio demasiado alto, según la BBC.

Un total de El 39% de los resultados de nivel A publicados el jueves pasado fueron degradados , y los alumnos de las zonas desfavorecidas fueron los más afectados de forma desproporcionada, dice NS Tech , una división del New Statesman.

El algoritmo predijo las calificaciones después de recibir varios bits de datos.

La primera fue la calificación prevista por el maestro para cada alumno en función de su desempeño en clase y los exámenes simulados, explica el sitio de noticias. Pero esto se consideró insuficiente por sí solo, por lo que también se pidió a los maestros que clasificaran a cada estudiante de mayor a menor en términos de su calificación esperada.

Las escuelas se dedicaron a la tarea de evaluación, agrega The Times, y los jefes de departamento dirigieron reuniones en las que los maestros defendieron el caso de sus alumnos.

Pero, dice el periódico, hubo un problema en el sistema Ofqual. A reporte publicado por el regulador la semana pasada reveló que las calificaciones asignadas por los maestros solo tenían prioridad en clases de menos de 15 estudiantes, un sistema que favorecía a las escuelas privadas con clases más pequeñas.

Por el contrario, para los alumnos de escuelas más grandes, las calificaciones se vieron mucho más influenciadas por el desempeño histórico de la escuela y la clasificación de sus maestros que las calificaciones previstas, agrega NS Tech.

Esta discrepancia explica el número desproporcionado de estudiantes de escuelas que normalmente no envían alumnos a las mejores universidades del Reino Unido que vieron cómo sus calificaciones previstas se degradaron agresivamente.

¿Era posible un sistema más justo?

De acuerdo a Los tiempos Tom Whipple, editor de ciencia, hacer un algoritmo justo es como tratar de desatar un huevo, es decir, imposible.

El problema, escribe Whipple, es que cuando las personas extrapolan datos de población para hacer predicciones sobre individuos ... puedes terminar cometiendo todo tipo de errores contraintuitivos, sorprendentes y, a veces, absurdos.

Esto es lo que salió mal con un algoritmo basado en gran medida en los resultados históricos de una escuela, argumenta. Claramente, esto será injusto para los niños excepcionales en escuelas no excepcionales, mientras que a la inversa, será demasiado amable para los niños no excepcionales en escuelas excepcionales.

Sam Freedman, director ejecutivo de la organización no gubernamental Education Partnerships Group, está de acuerdo con este veredicto. Inevitablemente, el algoritmo iba a afectar a los estudiantes atípicos que estaban en la parte superior de la distribución en las escuelas que no habían tenido muchos estudiantes de alto rendimiento en el pasado, dijo. tweets .

Pero, agrega Freedman, la decisión del gobierno de usar solo las calificaciones previstas por el maestro también es injusta para los alumnos de las escuelas que calificaron con cautela, injusta en las cohortes pasadas / futuras y crearon [d] una lotería para las universidades.

Y el cambio de sentido puede llegar demasiado tarde para algunos estudiantes, y muchas universidades dicen que los cursos para el próximo año académico ya están completos.

En cuanto al algoritmo, las estadísticas son, por definición, una forma de representar muchos números en menos números, dice Whipple.

Esto es tremendamente útil, pero necesitamos saber qué significa: olvidarse del individuo.